北京时间8月5日消息,据国外媒体报道,上周一一千多名人工智能研究人员联合签署了一份公开信,催促联合国禁止自主武器的研发和使用。这封公开信在阿根廷布宜诺斯艾利斯召开的2015年人工智能国际联合会议上展示,签署的科学家都是研究人工智能的著名科研人员,例如谷歌研发主管皮特•诺维格(Peter Norvig)、特斯拉和SpaceX公司的CEO埃隆•马斯克(Elon Musk)以及物理学家斯蒂芬•霍金(Stephen Hawking)。

自上周一起,又有超过16000人签署了这封公开信。

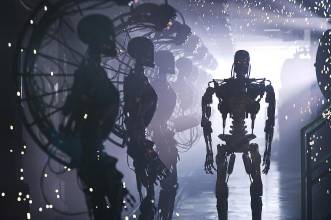

这封信阐述了自主武器或者无需人类在控制端操作即可定位和开火的武器的研发可能会引发“战争的第三次革命”,类似前两次武器和核弹的创造。

虽然杀人武器听上去非常可怕,但由成熟的人工智能驱动的武器或可能比人类战士更适合,其实存在某些真实的原因。自主武器可以让人类士兵远离火线突击,潜在的减少战争的伤亡人数。杀人机器人其实是更好的战士,他们更快、更精确、更强大,也可以承受比人类更多的物理损伤。

人工智能研究人员、文章《人工智能:现代方法》的合作作者斯图尔特•罗素(Stuart Russell)是禁止自主武器的提倡者之一。即使他担忧自主武器可能落入坏人手里,但他承认自主武器存在某些更有效的论点。“我有很长一段时间在思考我应该采纳什么态度,” 罗素说道。“它们可以异常的高效,它们具有比人类更快的反应速度,也更精确。它们没有身体因此无需生命支持。我认为这些是很多不同军队,不仅仅是英国也包括美国研发自主武器的主要原因。”

自主武器不会害怕、怯场或者大发脾气。他们可以冷静的完成任务,而不会因为情绪左右自己的行为。 电气与电子工程学会期刊IEEE Spectrum的埃文•艾克曼(Evan Ackerman)写道,可以对自主武器进行编程要求它遵循主导战争的交战原则和其它规则。

“如果一个恶意目标也有武器,且武器对准你,你可以在对方武器开火之前交战,而非之后为了自我保护才交战。” 艾克曼写道。“机器人可能更加警觉,你可以对它们进行编程,让它们不要以致命的火力与恶意目标交战,除非他们具有一定的把握(你可以设定所需确实定性程度)对方已经主动开火。”

机器人论理学家肖恩•韦尔什( Sean Welsh)对这一观点也做出了回应,他表示杀人机器人“将完全关注于国际人权法的约束,因此理论上来说比人类战士更可取,因为后者可能会惊慌、寻求报复或者把一切弄得一团糟。”

艾克曼建议废除科技“非好即坏”这一误解,而是关注科技被使用的方式。他建议提出一种让“自主武器机器人更有道德”的方法。“任何技术都可以用于作恶,” 艾克曼写道。“如果问题是人类将技术用于作恶的意愿性,那么禁止这项技术并不能解决这个问题,我们需要一份更大的请愿书。”

这份请愿书的贡献者之一、美国丹佛大学约瑟夫-克贝尔国际研究学院希瑟•罗夫(Heather Roff)对此并不赞同。“美国军队并不想要放弃智能武器,” 罗夫说道。“坦白来说,我并不想要他们放弃。这些是有区别的武器。然而,我们也希望限制那些没有人类控制的不同武器的向前发展。”

很有可能这次近期的公众强烈抗议还不足以阻止国际战争武器,目前已经研发了半自动武器来自主鉴别和瞄准目标。其中很多,例如澳大利亚海军的反导弹和近战武器系统,并未得到任何详细检查或者反对。

“这是为什么?因为它们被用于海上且当对方是以非常恶意的方式靠近的情况时,”国防研究人员杰•加约(Jai Gaillot )这样说道。“也就是说,它们只被部署在杀死无辜平民的风险几乎为零的背景和环境里,而非常规的战斗过程中。”

也许现在已经无法阻止历史先前滚动的车轮,“阻止人们研发这类武器系统的障碍已经非常小了。”

cnBeta 已经入驻豌豆荚啦,扫描左侧的二维码就可以在豌豆荚关注我们。

最懂应用的豌豆荚,发现无数好应用。

未经允许不得转载:陈丹的博客 » 研发自主杀人武器不可避免 世界或陷入第三次战争革命

陈丹的博客

陈丹的博客